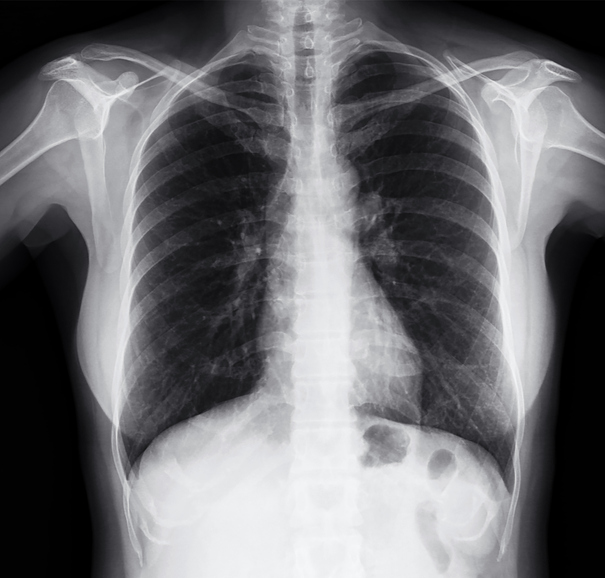

医療画像AIを利用した疾患検出技術について、多方面での研究開発が進むが、「トレーニングデータにおける患者背景の網羅性の不足」が問題となっている。英国のインペリアル・カレッジ・ロンドンの研究者らは、胸部X線AIモデルに潜む人種および性別に関するバイアスの存在を浮き彫りにし、今後の臨床応用への課題を示した。

Radiology: Artificial Intelligenceに発表された同研究では、インドと米国から得られた80万枚以上の胸部X線画像を用いて構築された最新の胸部X線AIモデルの性能を詳細に検証した。バイアス解析の結果、性別間に加え、アジア系および黒人患者において、疾患検出の精度に有意な差が存在することが確認された。具体的には、女性患者においては「所見なし」の分類精度が6.8-7.8%低下し、黒人患者における「胸水」の検出精度が10.7-11.6%低下していたという。

研究責任者であるBen Glocker博士は、「データセットの大きさだけでは公正なAIモデルの構築は保証できない。多様性と代表性を確保するため、データの収集段階から細心の注意が必要だ。AIはブラックボックスと思われがちだが、箱を開けて機能を検査することは可能だ。データセットを収集する際には、その初手から、全てのユーザーにとって有益な方法でAIが使用されていることを保証する必要がある」と語った。

参照論文:

Risk of Bias in Chest Radiography Deep Learning Foundation Models

関連記事: