米ノースカロライナ州立大学の研究チームは、AIが2次元画像から3次元空間を認識する際、空間内でのオブジェクトの関連性把握を向上させる「MonoCon」と呼ばれる新技術を開発した。

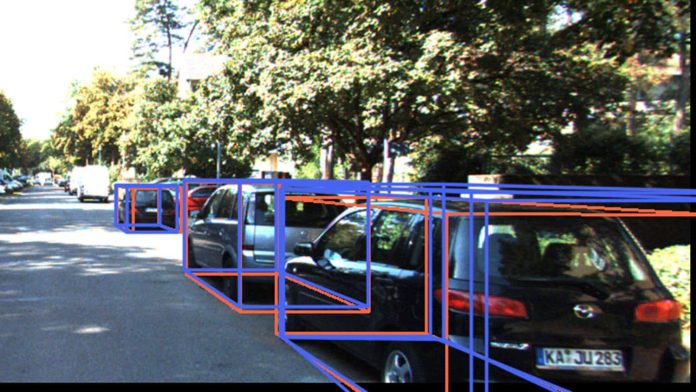

現実環境は3次元で構成されている一方、現時点で基本的な画像記録は2次元で行われる。あらゆるAIプログラムはカメラからの視覚入力を受け取って処理を加えるが、現実環境と適切にインタラクトさせるには、2次元画像から3次元空間についての適切な情報解釈が必要となる。同大学が明らかにしたところによると、MonoConも既存のAI学習方法と同じく、オブジェクトを「3次元バウンディングボックス」に配置しながら学習を進める。さらに本システムでは、カメラからオブジェクトまでの距離とバウンディングボックスの寸法を予測させるだけでなく、ボックスの8つの点(角)の位置、およびボックスの中心からの距離を2次元で予測させている。これを「補助コンテキスト」と呼び、2次元画像を元に、AIが3次元オブジェクトをより正確に識別・予測するのに役立つことを研究チームは明らかにした。

自動運転車両で注目を集めるLiDARはセンサー自体が高価なこともあり、量産品に多量のLiDARセンサーを搭載することは現実的ではない。一方で、MonoConは安価な一般的カメラを用いて、3次元情報を高精度に得ることを可能とするため、多量配置への敷居が低い点も強みとなる。MonoConの潜在的な適用範囲は非常に広範で、医療分野にも期待が大きい。

関連記事: